Les assistants numériques tels Siri d’Apple ou Alexa d’Amazon, qui utilisent d’origine une voix féminine, confirment les préjugés sexistes. Voilà ce qui ressort d’une étude effectuée par les Nations Unies.

“Ces assistantes sont présentées comme obligeantes et toujours prêtes à faire plaisir”, ce qui confirme le préjugé de la femme soumise, dénonce l’étude. Ce qui est particulièrement inquiétant, c’est le fait que les assistantes “émettent souvent des réactions fades, voire trouvent des excuses à des insultes”. Le rapport de l’Unesco est intitulé ‘I’d blush if I could’ (‘Je rougirais si je le pouvais’) d’après la réaction de Siri, lorsque l’utilisateur lance à l’appareil des injures à connotation sexuelle.

Selon le rapport, ce problème est partiellement dû au fait que ces assistantes sont majoritairement conçues par des ingénieurs masculins, ce qui fait qu’elles répondent aux offenses par un léger tremolo dans la voix. “Comme la voix de la plupart des assistants numériques est féminine, c’est bien là le signe que les femmes sont des aides dociles, qui se manifestent sur une simple pression sur un bouton ou par une commande vocale rustre du type ‘hey’ ou ‘ok'”, indique encore le rapport. “Dans beaucoup de sociétés, cela ne fait que renforcer encore les préjugés existants, selon lesquels les femmes sont dociles et supportent les mauvais comportements.”

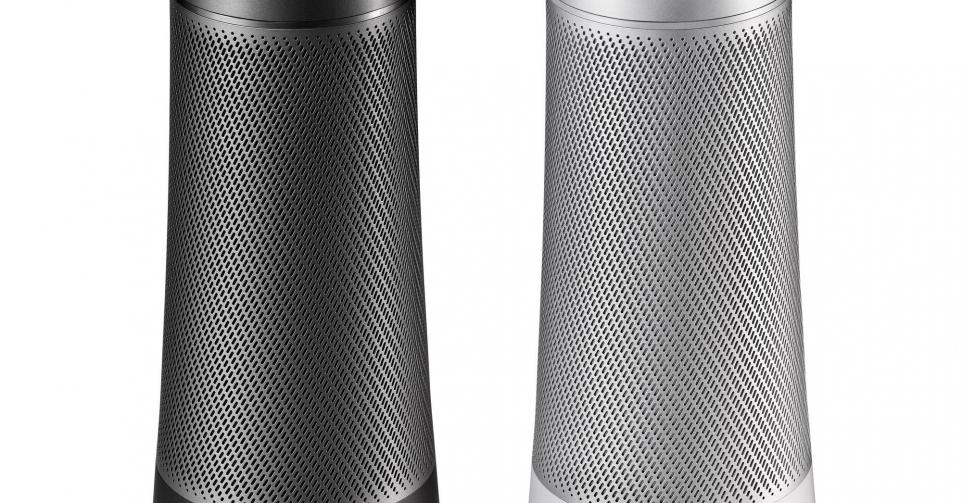

L’année dernière, on estime que 100 millions de haut-parleurs intelligents environ ont été vendus. Le rapport de l’Unesco invite les entreprises technologiques à ne pas donner par défaut une voix féminine à ces haut-parleurs assistants, mais à choisir une voix numérique davantage neutre. C’est ce sur quoi planche une équipe de chercheurs de Copenhague dans le cadre du projet Q.