Dans les années à venir, on s’attend à une forte croissance du contenu en ligne généré par l’IA. Or l’intelligence artificielle sous-jacente est souvent formée sur du contenu se trouvant sur internet. Certains chercheurs en IA ne voient pas d’un bon œil la ‘consanguinité’ qui en résulterait dans le processus d’apprentissage et qui, selon eux, pourrait conduire à une implosion complète du contenu généré par l’IA.

L’agence européenne d’application de la loi Europol a récemment averti que d’ici 2026, 90 pour cent de tout le contenu en ligne sera généré de manière synthétique et donc créé par des systèmes d’intelligence artificielle tels que GPT-4. Et même si tel ne devait pas être le cas, il ne fait aucun doute que nous lirons à l’avenir de plus en plus de textes sur les sites web, qui auront été rédigés par une machine. Les modèles de langage sont utilisés avec de moins en moins de scrupules dans des domaines comme le marketing, la communication politique et le journalisme.

Cela est dû au fait que les modèles de langage sous-jacents aux générateurs de contenu IA tels que ChatGPT, Bing Chat et Bard sont devenus incroyablement valables dans l’imitation du langage humain. Mais ce résultat n’est pas le fruit du hasard: les modèles de langage sont formés sur base de masses de contenus créés par des humains, et qui sont puisés d’internet dans le cadre d’un ‘processus d’apprentissage’ constant de l’IA. Mais que se passerait-il si du texte rédigé par des humains tombait très rapidement en désuétude et si des machines se mettaient surtout à se former à partir de contenus écrits par d’autres machines?

Consanguinité des données

Il en résulterait des choses bizarres, estiment plusieurs experts informatiques impliqués dans le développement de systèmes d’intelligence artificielle. L’IA qui se formerait sur du contenu créé par l’IA, ferait apparaître du nouveau contenu qui deviendrait de moins en moins utile. Le chercheur en données Jathan Sadowski, de l’université australienne Monash, a qualifié la sortie ‘mutilée’ d’un texte généré par l’IA qu’il a, sur base d’une expérience, fait traiter par une autre IA pour qu’il devienne un nouveau texte, ‘de système qui a été si intensivement formé sur les créations d’une autre IA générative qu’il devient un mutant consanguin aux traits exagérés et grotesques.’

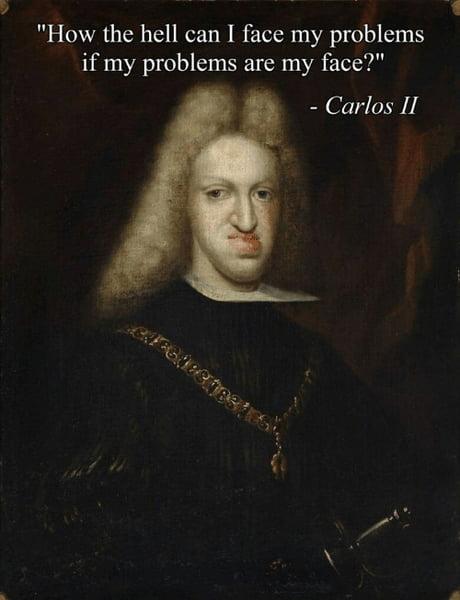

(Sadowski l’appela ‘Habsburg AI’, en référence à des branches de la dynastie des Habsbourg où, selon des historiens, la consanguinité était à ce point pratiquée au dix-septième et au dix-huitième siècle que les jeunes descendants souffraient de graves malformations. Le plus connu d’entre eux fut Carlos II d’Espagne, dont l’occlusion exagérée fait l’objet de nombreux mèmes sur Facebook.).

Autophagie

Le problème avec ce contenu consanguin est qu’il s’accélérera de lui-même, selon le professeur Richard G. Balanick de la Rice University de Houston aux Etats-Unis. Au site web Futurism, il a expliqué qu’une ‘boucle d’autophagie’ commencerait à se manifester. ‘C’est auto-dévorant. Pensez à un animal qui non seulement court après sa queue, mais qui la mange aussi. Si on agit ainsi génération après génération, les artefacts – de petites erreurs de production – seront amplifiés. Les données synthétiques s’éloigneront de la réalité. On générera des images qui seront toujours plus monotones et ennuyeuses. Il en ira de même pour le texte.’

Plusieurs étudiants de Balanick ont déjà effectué des recherches à ce sujet et ont donné au phénomène un titre officiel: MAD (Model Autophagy Disorder). Selon leurs recherches, il ne faudra que cinq cycles de données générées par des machines et traitées par d’autres pour en arriver à des résultats complètement inutilisables.

Talon d’Achille

Cela représente un talon d’Achille potentiel pour toute l’idée du contenu généré par l’IA. Ou pire. Car le problème peut s’étendre à l’ensemble d’internet, prévient Balanick: ‘Il ne fait aucun doute que MADness a le potentiel de réduire sensiblement la qualité des données sur internet. Si on forme les type de systèmes IA utilisés dans les moteurs de recherche à l’aide de données synthétiques et de données réelles, les performances chuteront. Plus il y aura de données synthétiques et plus les performances de toute une série d’outils, dont les moteurs de recherche, pourraient diminuer.’