Des chercheurs de la KU Leuven ont mis au point un modèle capable de mystifier un détecteur de personnes. En portant autour du cou un petit panneau en carton où figure ce modèle, vous pourriez vous rendre invisible à une caméra de surveillance intelligente.

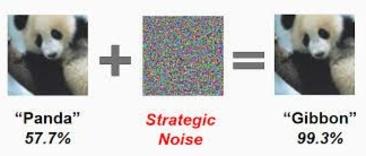

Les systèmes d’intelligence artificielle (AI) ont un autre regard sur les choses que nous, les humains. On sait depuis assez longtemps déjà que de subtiles adaptations peuvent faire en sorte que les systèmes AI interprètent des images d’une manière totalement différente. En ajoutant par exemple une fine couche numérique sur l’image d’un panda, il est possible de faire croire à un tel système qu’il s’agit d’un gibbon.

Des chercheurs de Google Brain, le centre de recherche AI de Google, avaient déjà signalé que ce genre de manipulation est aussi possible dans le monde réel. En imprimant simplement les images manipulées et en les photographiant avec un smartphone, ils avaient réussi à berner des systèmes AI. Même les voitures autonomes, qui utilisent la reconnaissance de modèles, peuvent en principe être ainsi piratées. Voilà ce qu’ont démontré des chercheurs américains, il y a deux ans en recouvrant de stickers des panneaux routiers.

A présent, ce sont des chercheurs de la KU Leuven qui ont démontré pour la première fois qu’il est possible de mystifier aussi des algorithmes d’identification de personnes. Ils décrivent leur technique dans un rapport qu’ils ont posté la semaine dernière sur la plate-forme électronique ArXiv et qui a été passé en revue par le site technologique américain The Verge.

Cette technique de camouflage permettant de contourner la détection de personnes, qui y est présentée, a aussi été testée dans des scénarios de la vie de tous les jours. Un modèle imprimé sur un bout de carton tenu devant le ventre semble suffire pour devenir invisible pour le détecteur de personnes, comme le montre la vidéo ci-dessous.

Vous pouvez modifier vos choix à tout moment en cliquant sur « Paramètres des cookies » en bas du site.

L’image sur le panneau en carton ressemble à une peinture impressionniste de gens attablés sur une terrasse sous un parasol. Elle n’a pourtant pas été conçue par un humain, mais par une intelligence artificielle. “Nous avons ajusté le modèle par optimalisation en apprentissage machine, jusqu’à atteindre l’effet maximal voulu, qui était de tromper le plus efficacement possible la détection de personnes”, explique le professeur Toon Goedemé à Data News. La technique s’avère en outre résistante aux déformations: même si le panneau tourne ou bouge, il n’en continue pas moins de tromper le détecteur de personnes.

Son groupe de chercheurs s’est dans un premier temps concentré sur la mystification d’un algorithme spécifique, à savoir YOLOv2 (l’abréviation de You Only Look Once). “Nous avons testé notre attaque sur l’algorithme YOLO, parce que cette forme d’identification de personnes est souvent utilisée par les caméras de sécurité”, ajoute Goedemé.

La vulnérabilité des caméras de surveillance exposée par les chercheurs ne s’applique donc qu’aux systèmes, qui recourent à cet algorithme spécifique. “Un autre détecteur de personnes n’éprouvera à coup sûr aucun problème avec ce panneau. Dans un certain sens, cela a de quoi rassurer les fabricants de caméras de sécurité: s’ils utilisent un autre algorithme ou un algorithme formé sur base d’un autre ensemble de données, le modèle en question ne générera aucun risque”, précise Goedemé. “Mais nous pourrions facilement créer de nouveaux modèles destinés à berner d’autres algorithmes.”

Une course aux armements AI en devenir?

Cette vulnérabilité ouvrira en tout cas peut-être des perspectives pour les gens préoccupés par le respect de leur vie privée. Il est possible qu’ils envisagent de se camoufler dans ce ‘modèle d’invisibilité’ pour tromper les caméras de surveillance intelligentes. “Si l’on combine cette technique avec une simulation de vêtement sophistiquée, on pourrait concevoir un T-shirt, qui rendrait une personne virtuellement invisible pour une caméra de surveillance automatique (si elle utilise la technique YOLO)”, conclut le rapport. “Ce type de scénario frappe évidemment l’imagination. Du point de vue technique, cela ne pose en tout cas aucun problème d’imprimer le modèle sur un T-shirt et d’y prévoir même des déformations supplémentaires”, poursuit Goedemé.

Le secteur de la sécurité doit-il dès lors commencer à se faire du souci? “Considérons cela comme une course aux armements”, prétend Goedemé. “Nous pouvons très simplement rendre un algorithme résistant à ce genre d’attaque. Un détecteur de personnes est formé sur base d’un vaste ensemble de données de différentes personnes. Si on y ajoute un certain nombre d’images de personnes qui s’en tiennent au modèle développé, on pourrait déjà apporter une solution. Mais ensuite, ce robuste détecteur pourrait à son tour être trompé par un autre modèle exploitant la même technique. Et ainsi de suite. On peut toujours trouver des carences du genre dans la sécurité. Il nous appartient d’exposer les points faibles et de les corriger le mieux possible.”

Les résultats obtenus reposent sur le travail d’un étudiant, Simen Thys, dans le cadre de sa thèse de master, sous l’égide du chercheur post-doctorant Wiebe Van Ranst. La recherche a été effectuée chez EAVISE, un groupe qui fait partie de la faculté des sciences d’ingénierie industrielle sur le Campus De Nayer, le campus technologique de la KU Leuven à Sint-Katelijne-Waver. La recherche AI, qui y est menée, cible surtout les applications susceptibles de former un pont entre l’université et les entreprises. “Nous sommes partiellement financés par l’industrie et sommes ouverts à la collaboration avec les entreprises”, affirme Goedemé. “Cela va en tout cas nous inciter à intensifier notre recherche. Notre prochaine étape sera d’examiner si nous pouvons développer des modèles génériques capables de mystifier d’un coup plusieurs algorithmes.”