L’AI générative n’a plus honte de rien. Alors que ChatGPT élabore des articles complets et du code logiciel, et que des outils comme Stable Diffusion génèrent inlassablement de nouvelles séquences, la technologie gagne toujours plus intensivement le monde de la musique. Ou comment Oasis – sans même l’intervention des frères Gallagher – sort de nouvelles chansons telle qu’AIsis, alors que Freddie Mercury reprend impeccablement les classiques des Beatles plus de trente ans après sa mort.

Le mariage entre la musique et l’intelligence artificielle est moins récent que ce qu’on pourrait penser. En 1960 déjà, le chercheur russe Rudolf Zaporiv publia un premier article consacré aux compositions musicales algorithmiques au moyen d’un ordinateur Ural-1. Cinq ans plus tard, l’inventeur américain Ray Kurzweil sortit en exclusivité un morceau pour piano créé par ordinateur. Une autre étape importante fut Experiments in Musical Intelligence (EMI), un programme de 1997 capable de composer de la musique classique dans le style de Bach. Finalement, EMI évolua pour devenir Emily Howell, un logiciel qui parvint en 2009 à sortir son propre album.

‘C’est comme si une boîte de voix robotisées s’ouvrait quelque part pour interpréter des succès avec la voix contrefaite d’autres artistes.’

C’était là de la musique générée par l’AI ‘avant la lettre’. Car malgré ce préhistorique respectable, ce n’est que maintenant que le grand public découvre vraiment ce genre musical peut-être complètement nouveau, comme l’avenir nous le dira. Cela est dû d’une part à l’intérêt rapidement croissant pour l’intelligence artificielle, alimenté par le battage médiatique autour de ChatGPT, mais d’autre part surtout à l’explosion de la musique AI ces dernières semaines.

Il suffit de demander, et l’AI fait le reste

C’est comme si une boîte de voix robotisées s’ouvrait quelque part, pour interpréter des succès avec la voix contrefaite d’autres artistes. Le fait que le/la chanteur/se original(e) ne soit parfois plus de ce monde depuis des années, l’AI générative n’en a cure: mort ou vif, peu importe finalement, puisque le résultat est souvent terriblement ‘vrai’. Tout s’est soudainement accéléré fin avril avec Heart on my Sleeve, une chanson créée par l’AI et interprétée par les voix clonées de Drake et de The Weeknd. Le cerveau à l’origine de ce morceau, un certain @ghostwriter, a révélé que la chanson avait été générée à l’aide d’un logiciel formé sur base des voix des chanteurs. Et que ce n’était ‘encore que le début’…

Tout cela ne semblait certes pas encore très authentique, mais c’était en tout cas bien parti et dans les jours et semaines qui suivirent, apparurent les premières ‘fake tracks’ (fausses pistes) qu’on pouvait à peine distinguer des vraies. ‘Michael Jackson’ et – de nouveau – ‘The Weeknd’ par exemple sortirent leur propre version de Get Lucky. Et à présent, il n’y a plus rien qui soit abusif. On a ainsi déjà entendu le regretté Freddie Mercury chanter Thriller et des hits des Beatles, Kanye West interpréter Hello d’Adele, Kurt Cobain accompagner le pote des Foo Fighters, Dave Grohl, et l’ex-président Barack Obama reprendre Let It Go. Il suffit de demander, et l’AI fait le reste.

Clonage de voix

Avec tout le respect, c’est aussi de la musique générée par l’AI dans sa forme ‘la plus simple’: la mélodie et les paroles restent inchangées, seule la voix change ou, plutôt, est remplacée artificiellement par celle de quelqu’un d’autre. La technologie le permettant implique essentiellement la formation et le développement d’un modèle de voix AI. Le clonage de voix, comme ce processus est également appelé, exige d’énormes quantités de données audio de la personne dont on souhaite imiter la voix. Dans le monde de la musique, il est évidemment présent en abondance. La seule chose à faire pour distiller de nombreux fragments de voix et de parole à partir d’un catalogue musical, c’est séparer la voix chantée des instruments. Il existe des logiciels très spécialisés pour ce faire, mais on y arrive déjà très bien avec un outil gratuit comme Audacity.

L’étape suivante consiste en la formation d’un réseau neural en l’alimentant avec le plus de données vocales possible. Au bout d’un certain temps, le système sera capable par apprentissage machine de générer de nouveaux sons – dans ce cas chantés -, dont la voix semble quasiment identique à celle du chanteur ou de la chanteuse ‘cloné(e)’. Comme pour tous les modèles AI, de GPT-3 à DALL-E, c’est le même principe qui s’applique: plus il y a de la pratique et donc de données fournies, meilleur est le résultat.

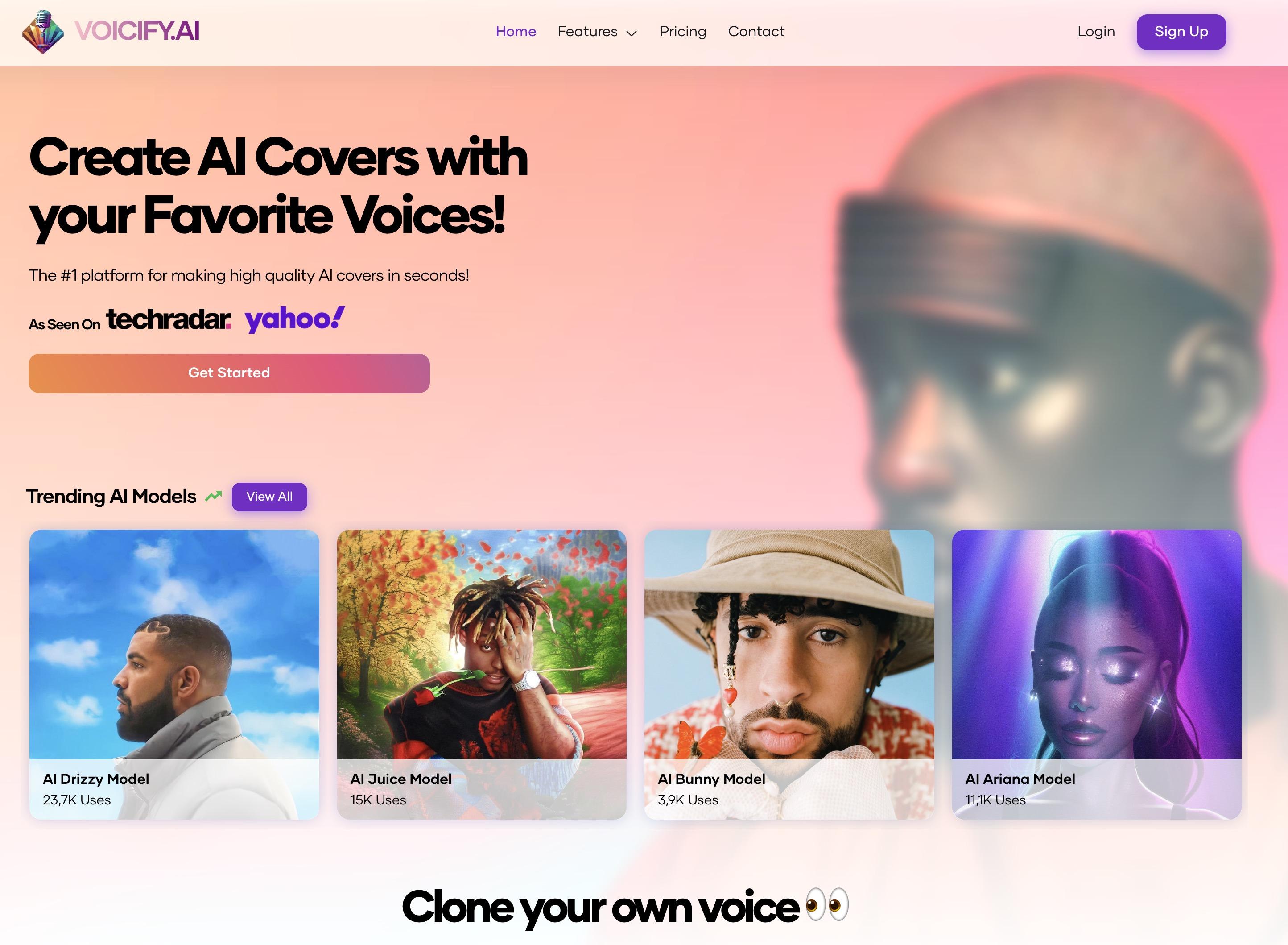

Entre-temps, de nombreuses voix imitées sont donc à ce point valables qu’ici et là, de petites entreprises ont vu le jour pour en tirer parti. En guise d’exemple, citons le site Voicify.ai, où une douzaine de modèles vocaux AI sont dès à présent ‘en location’. Il suffit simplement ici de déposer une chanson (comprenez: la télécharger dans un format tel mp3), voire d’apposer l’URL d’une vidéo YouTube pour ensuite l’entendre interpréter par un autre artiste au choix. Ariana Grande, Justin Bieber, Eminem, Drake (de nouveau lui), Taylor Swift ou Harry Styles, pour ne citer qu’eux. Il n’est dans ce cas même plus nécessaire de séparer la voix des instruments, car Voicify.ai le fait à votre place. Le prix: 8,99 euros pour 25 crédits, chacun bon pour une chanson générée AI, soit 24,99 euros par mois.

Envie d’expérimenter par vous-même la musique AI?

Sur le web et sous forme d’appli, plusieurs outils sont disponibles qui vous aideront, grâce à leur touche AI, à composer votre propre musique. Comme AIVA par exemple, qui a vu le jour en 2016 déjà, mais qui poursuit inlassablement son apprentissage. Cet outil vous permettra de modifier des chansons existantes ou d’en créer de nouvelles à partir de zéro. Un autre générateur de musique AI s’appelle Soundful. Quiconque met en boîte ses propres vidéos, streams ou podcasts, ne pourra que profiter de cet outil pour produire de la musique d’ambiance libre de droit. Autre outil à ne pas manquer dans ce bref aperçu, car produit par l’auteur de ChatGPT, OpenAI, c’est MuseNet. Il s’agit d’un réseau neural alimenté par des centaines de milliers de fichiers MIDI et capable ainsi de prévoir des modèles, harmonies et rythmes musicaux. Il en résulte de nouvelles compositions de quatre minutes avec dix instruments et ce, dans des styles qui varient de ‘Mozart aux Beatles’. Vous préférez créer une mélodie sur votre smartphone? Chargez dans ce cas Amadeus Topline sur votre iPhone et générez des morceaux inspirés de vos plages favorites. Autre logiciel à tenir à l’œil: MusicLM de Google, un outil (pas encore en production) qui sera bientôt capable de transformer vos paroles en un morceau de musique original, comme l’affirment les développeurs.

D’autres paroles…

En outre, l’intelligence artificielle permet de générer des lignes vocales pour de nouvelles paroles de chansons. Un très bel exemple nous est fourni par la toute récente version de l’evergreen Yesterday des Beatles, qui débute par les paroles ‘Yesterday… was two days before tomorrow’. Faux au possible, mais on jurerait entendre le vrai Macca.

Une fois que vous pouvez faire dire ou chanter ce que vous voulez à une voix clonée – ce qui est le cas depuis quelque temps déjà -, il devient vraiment très malaisé d’encore vérifier l’authenticité d’un message ou d’une chanson. Et cela engendre actuellement pas mal de questions sur des préoccupations éthiques et juridiques (est-ce autorisé?), voire financières. Car qui est encore pris en considération pour les royalties ou voit l’argent lui passer sous le nez? Et le chanteur/la chanteuse qui est passé(e) par le moulin de l’AI, est-il/elle encore le/la propriétaire original de la voix clonée, lorsqu’il/elle produit soudainement des paroles complètement différentes? Nos collègues de Trends-Tendances approfondissent du reste la question des droits d’auteur dans cet article.

Parmi les artistes eux-mêmes, les avis sont partagés. Le DJ David Guetta est fan et estime que l’avenir de la musique appartient à l’AI. Dans une interview accordée à la BBC, la superstar française a annoncé s’attendre à ce que toujours plus de musiciens se tournent vers l’intelligence artificielle ‘parce que chaque nouveau style musical dérive d’une nouvelle technologie’. De leur côté, Nick Cave et Sting sont moins enthousiastes, et ce n’est pas peu dire. Cave a récemment reçu d’un fan quelques paroles dans le style de ce qu’il fait, mais générées au moyen de ChatGPT. Le leader de Bad Seeds n’a pas été impressionné, comme il l’a écrit dans sa lettre de nouvelles The Red Hand Files. ‘Les chansons sont placées sous le signe de la souffrance. Je veux dire par là qu’elles reposent sur la lutte humaine complexe et intérieure de la création. Pour autant que je le sache, les algorithmes ne ressentent rien, et les données ne peuvent souffrir.’

Sting n’a lui non plus pas vraiment apprécié les chansons AI qu’il a déjà entendues. ‘C’est comme regarder un film plein d’effets spéciaux numériques’, a-t-il déclaré dans une interview accordée à la BBC. Et d’ajouter: ‘Les bases de la musique nous appartiennent à nous, l’humanité. Selon moi, ce sera le combat que nous devrons livrer dans les années à venir: défendre notre héritage humain contre l’intelligence artificielle.’

… jusqu’à de nouvelles chansons

Peut-on générer aussi une toute nouvelle musique avec l’intelligence artificielle? La réponse est oui, mais avec une solide objection. Dans une récente opinion parue sur DataNews.be, Bram Vromans, Chief Digital Officer chez Ikea, mais aussi producteur de musique, tenait ces propos: ‘Décrire ce qu’on souhaite entendre, en dehors du genre et d’une certaine ambiance, c’est bien plus difficile que de décrire ce qu’on veut voir (avec des outils AI tels Stable Diffusion, Midjourney, ndlr). Je produis moi-même de la musique dansante et je peux en toute honnêteté dire que la musique actuelle générée par l’AI est de plus piètre qualité que ce que je fais moi-même. Cela est dû au fait qu’il y manque la créativité de l’artiste, les nouvelles techniques et les indispensables effets, puisque l’AI ne peut s’appuyer que sur ce qui existe déjà.’

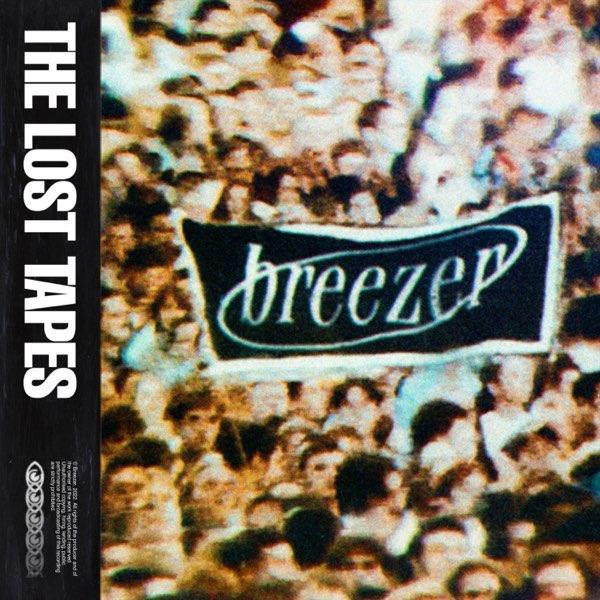

Mais en se faisant aider par l’AI, un artiste ou un groupe connu est capable de sortir vraiment une nouvelle musique et ce, même sans y être impliqué physiquement. ‘Nous en avions tout simplement assez d’attendre la sortie d’un nouvel album d’Oasis. Et nous l’avons donc fait nous-mêmes’, prétend Bobby Gerathy dans une interview accordée au journal britannique The Guardian. Gerathy, c’est cinquante pour cent du groupe Breezer (plutôt inconnu chez nous) et, conjointement avec son compagnon Chris Woodgates, le cerveau derrière AIsis. Bref, les musiciens ont pris huit de leurs propres chansons de Breezer avec, comme point de départ, des paroles uniques, puis ils ont remplacé au moyen de l’AI la voix de Gerathy par celle du leader d’Oasis Liam Gallagher. Il en résulta The Lost Tapes (lien Spotify), un longplay qui – vous l’auriez déjà deviné – ne peut quasiment pas être distingué d’un album vraiment nouveau d’Oasis, comme en témoigne déjà le premier morceau Out Of My Mind. ‘C’est même mieux’, estiment les membres de Breezer. ‘Car à vrai dire, la musique des frangins Gallagher n’a fait que se détériorer au fil des ans, pas vrai?’

Hasard ou pas: suite à un long conflit ayant opposé Noel et Liam, on a ces derniers jours vu se multiplier des rumeurs faisant état d’une prochaine réconciliation avec, à la clé, un certain nombre de concerts de retrouvailles d’Oasis en 2025. Une chose est sûre: il ne manquera pas de nouveau matériel d’ici là!