Quiconque possède une carte vidéo RTX, pourra bientôt générer localement un chatbot qui fournira des réponses basées sur un document ou toute autre saisie.

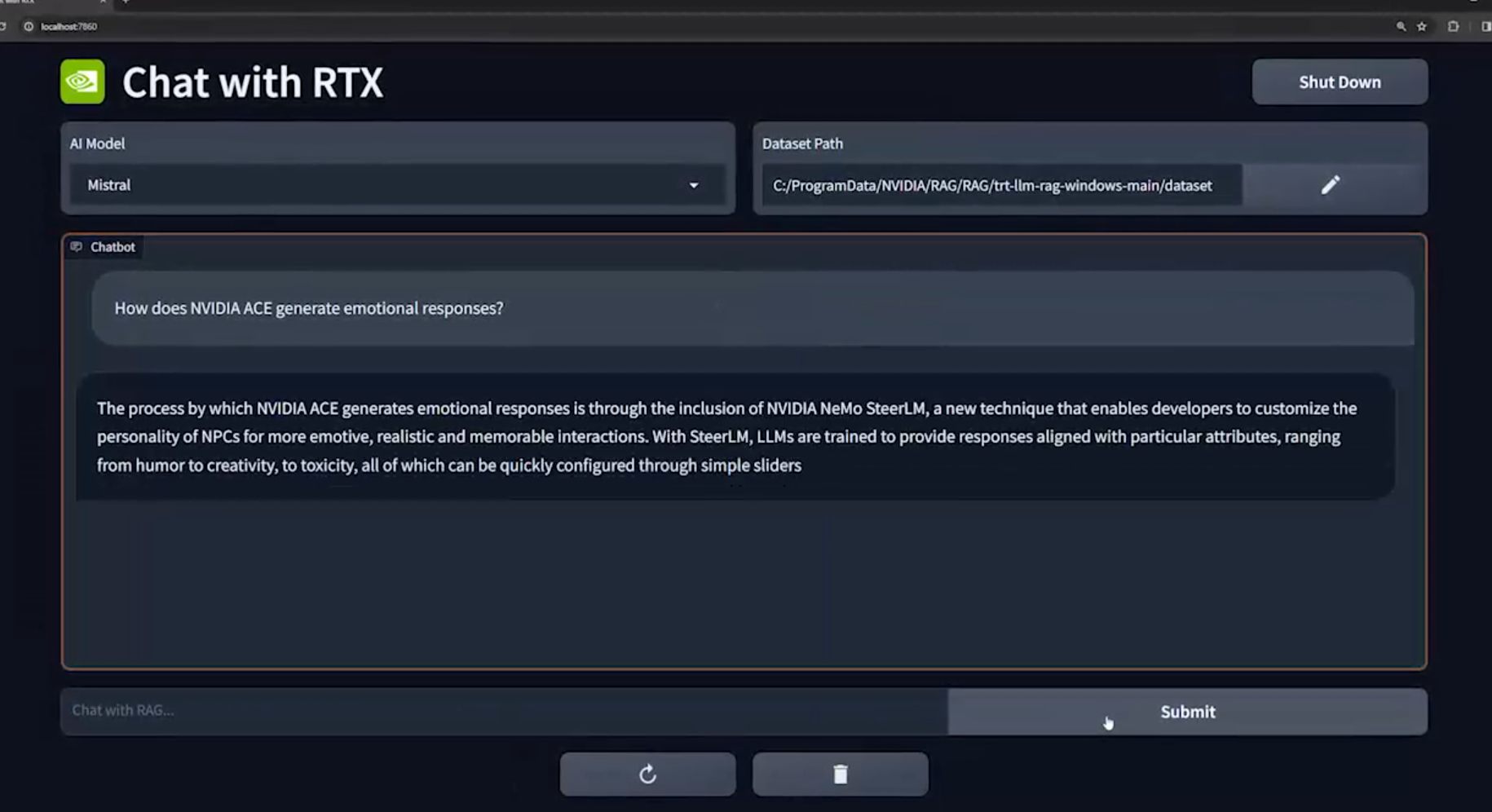

Sous l’appellation ‘Chat With RTX’, Nvidia annonce une démo dans laquelle vous indiquez un document ou autre fichier texte, avant de poser des questions auxquelles vous obtenez des réponses sur base du contenu de ces documents. De cette façon, vous pourrez créer une variante locale de services tels que ChatGPT ou Google Bard, qui extrait les informations de vos propres saisies.

Chat With RTX devrait être largement disponible sous forme de démo le mois prochain, mais uniquement pour ceux qui possèdent un PC (ou un poste de travail) Windows avec carte vidéo RTX. On ignore du reste dans quelle mesure il doit s’agir d’une carte RTX récente, les cartes les plus anciennes de la série existant depuis 2018, à commencer par la série RTX 20xx (comme les RTX 2060 ou 2080).

De nombreux détails sur ce qui sera possible ou non, ne sont pas encore connus. C’est ainsi qu’on ne sait par exemple pas si vous ne pourrez utiliser qu’un seul fichier à la fois ou si vous pourrez faire analyser des années d’archives de textes personnellement écrits, afin de créer un nouveau texte à partir de ceux-ci. En théorie, vous pourriez alimenter un tel système avec un seul gros fichier texte, mais on ignore encore s’il y aura des limites en pratique. Il s’agit actuellement d’une démo, sans beaucoup d’informations sur une éventuelle version étoffée.

L’un des arguments en faveur d’un tel robot d’IA générative local est qu’il pourrait fonctionner relativement rapidement, mais qu’il est également plus sûr. Les données que vous fournissez vous-même au système ne prennent en effet pas la direction du cloud, ce qui rend plus fiable le partage d’informations sensibles avec le programme.

Informations issues de vidéos YouTube

En plus de différents formats de document, Chat With RTX aurait également la possibilité de recevoir des URL de YouTube, décrivant ensuite les vidéos et traitant ces informations dans le chatbot local. En outre, Nvidia parle également d’’autres données’, mais sans détailler ce qui sera ou non supporté.

Bien que les systèmes d’IA générative basés sur le cloud tels que ChatGPT soient les plus connus, des LLM locaux existent depuis un certain temps déjà, où le modèle de langage et ce qu’il en sort tournent entièrement sur votre propre PC. Mais les versions gratuites ou faciles d’accès sont plutôt limitées. C’est ainsi qu’il existe par exemple FreedomGPT, qui vous permet de faire tourner un chatbot similaire ‘non censuré’, mais qui, en pratique, s’avère très limité et peut rarement avoir des conversations significatives. L’expérience de Nvidia, combinée à la puissance de calcul locale des cartes RTX, pourrait dès lors générer un type complètement différent d’IA générative locale.