Une proposition au sein du Parlement européen en vue de conférer une personnalité juridique aux robots ouvre le débat plus large de ce qu’on peut attendre de ceux-ci et des limites à leur fixer.

Les robots doivent-ils avoir des droits ? Voilà une question bizarre qui tient en haleine des pans entiers de la Commission européenne. Pour suivre ce débat, il nous faut remonter une bonne année en arrière, jusqu’en janvier 2017. C’est à cette époque qu’une commission de recherche européenne en affaires juridiques sort un rapport recommandant des changements à la législation. L’objectif est de préparer l’Europe à la robotique et à l’intelligence artificielle – du moins sur le plan juridique. Parmi ces recommandations en matière de standardisation et de tests de sécurité, on trouve aussi dans le rapport la suggestion, selon laquelle les robots doivent obtenir une ‘personnalité juridique’.

Qui est responsable ?

Que les choses soient bien claires : une telle personnalité juridique ne s’apparente pas à une ‘Déclaration Universelle des Droits des Robots’, mais plutôt à la personnalité juridique d’une entreprise, selon Hans Graux, avocat chez Timelex, un bureau spécialisé en droit ICT. ” C’est plus ou moins la seule analogie qui existe. ”

Ces derniers mois, Graux a collaboré à une étude étoffée pour la Commission européenne et consacrée à la responsabilité en robotique et en intelligence artificielle. Si un robot ou une IA peut être jugée ‘responsable’, il devrait en principe être plus facile de lui réclamer un dédommagement. Si demain, vous trouvez des morceaux de verre dans votre pot de yaourt, vous ne devez pas, selon le raisonnement, rechercher qui exactement a commis la faute : vous pouvez porter plainte contre l’entreprise responsable. Il doit en être de même avec les robots. Et ce n’est pas une mauvaise idée en soi, selon Graux, mais : ” Il y a une raison simple qui nous fait dire explicitement que conférer une personnalité au robot est une bonne idée. Pour rendre quelqu’un responsable, cette personne doit avoir de l’argent. Responsabiliser quelqu’un qui n’en a pas, cela ne sert à rien car cette personne ne pourra pas indemniser un dommage. ”

Les entreprises possèdent un capital, au contraire des robots. Avant de pouvoir en arriver à une personnalité juridique, les robots devraient donc d’abord disposer d’un fonds permettant de régler des dommages causés. Or on n’en est pas encore là. ” Le conseil que nous avons finalement donné au terme de l’étude, déclare Graux. C’est qu’il y a différents aspects dans le droit de responsabilité, qui ne sont pas adaptés à la nouvelle technologie. Notre recommandation était donc qu’il fallait élaborer des règles de responsabilité spécifiques et absolument pas que les robots eux-mêmes devaient être tenus pour responsables. Ce qui serait judicieux, ce serait de détailler quelque peu davantage les règles existantes et d’en fixer des plus strictes pour des produits, tels les logiciels et l’AI, qui sont capables d’agir de façon déterministe. “

Il est dangereux de commencer à rédiger des lois sur base de règles fantaisistes.

Ce dernier point signifie que ces produits ‘font eux-mêmes un choix’ sur base de leur programmation. Comme c’est le cas de Waze, qui décide quelle est la meilleure route pour aller d’un point A à un point B. Mais aussi des voitures autonomes qui suivent cette route. ” L’idée est de prévoir une responsabilité accrue pour les entreprises en charge de ces produits, poursuit Graux. Il est ici non seulement question des entreprises qui fabriquent les robots, mais aussi de celles qui développent des services pour ceux-ci, comme ceux de taxis autonomes. La Commission européenne pourrait par exemple les contraindre à prendre une assurance spécifique ou à incorporer des boîtes noires pour qu’on sache ce qui s’est passé en cas de problème. ”

Un robot n’est jamais seul

Pour les esprits cyniques, tout ce débat prend dès lors aussi des allures d’excuse pour les fabricants de robots en vue de se décharger d’une partie de leur responsabilité. Les propriétaires de demain ne devront-ils plus verser des dédommagements, si leur voiture autonome fonce dans un étalage de magasin ? ” Cela dépendra de la façon d’implémenter ce type de responsabilité, ajoute Hans Graux. Il y a évidemment le risque de décharger une entreprise comme Waymo de sa responsabilité. Mais souvent, ce genre de loi est faite pour les gens qui trouvent la situation actuelle trop complexe. Il est à présent trop difficile pour les citoyens de se protéger. En cas de problème, est-ce la faute du matériel, du logiciel ou de l’utilisateur ? ”

Car les robots, tout comme chaque technologie moderne, sont une donnée complexe, qui le devient toujours davantage du reste, comme le déclare aussi le Prof. Dr. ir. Bram Vanderborght, qui enseigne la robotique à la VUB. ” Si une voiture autonome de Tesla provoque un accident, il n’y a qu’une seule entreprise responsable. Mais les robots du futur seront des plates-formes d’applis. ” Pour Vandenborght, la prochaine génération de robots ne fonctionnera pas de manière très différente de celle des actuels smartphones. ” Vous posséderez par exemple un robot-aspirateur, mais pourquoi ne servirait-il pas aussi à surveiller votre maison ? Pourquoi ne pas placer une caméra sur un robot-tondeuse, afin que vous puissiez voir si tout est en ordre durant vos vacances ? Ces appareils pourraient en effet intégrer de plus en plus de fonctions. ”

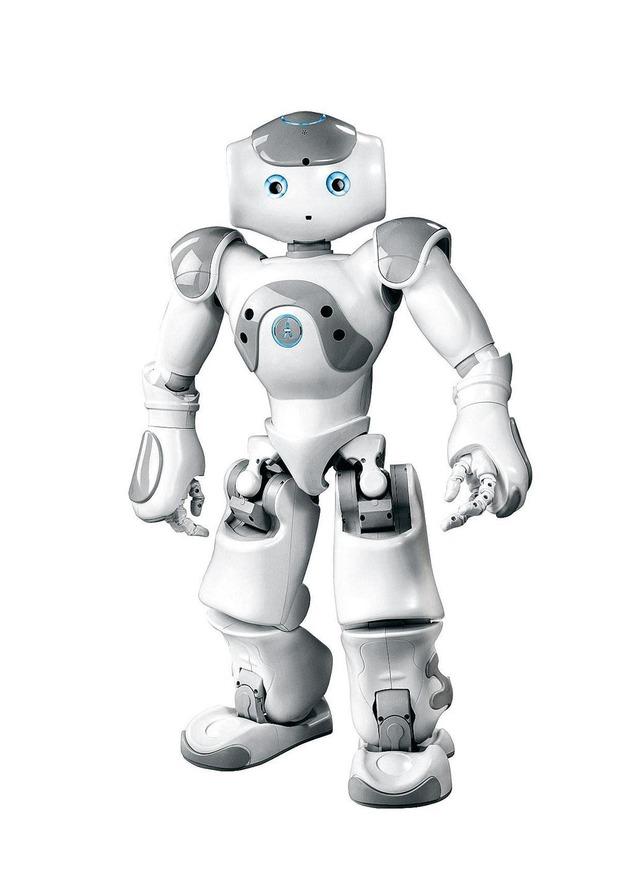

Les premiers signes de robots-plates-formes existent du reste déjà parmi les appareils humanoïdes de Softbank Robotics. Le plus connu est probablement le robot-réceptionniste Pepper. Une version plus compacte, le Nao, est non seulement populaire en tant que robot-footballeur, mais elle peut aussi, grâce à du software spécialisé, effectuer d’autres tâches. La firme française Zora se concentre elle sur les robots hospitaliers. Dans ces cas, il est déjà plus malaisé de déterminer qui est responsable en cas d’erreur.

Nombre de services que les robots utiliseront, comme la reconnaissance faciale, se passeront dans le nuage. La question est alors de savoir jusqu’où peut aller le robot ?

” Certes un petit robot tel Nao ne peut blesser personne, prétend Vanderborght. Mais s’il reçoit plus de travaux à effectuer, il faut déjà qu’il soit à la hauteur. Que se passera-t-il si on installe une appli de sécurité domotique sur un robot humanoïde et s’il blesse quelqu’un ? Qui sera responsable ? Il s’agit d’un secteur très jeune. Il convient donc de trouver le juste équilibre entre la garantie de droits humains et l’assurance que ce secteur ne soit pas étouffé par les problèmes juridiques. ”

Et c’est sans parler de la manière dont le software se manifeste d’ores et déjà dans la réalité. ” Nombre de services que les robots utiliseront, comme la reconnaissance faciale, se passeront dans le nuage. La question est alors de savoir jusqu’où peut aller le robot ? “, conclut Vanderborght.

Jusqu’où peut aller le robot ?

A présent que toujours plus de technologies sont conçues avec des algorithmes et l’apprentissage machine, la façon dont les logiciels sont créés et la source à partir de laquelle un robot prend ses décisions, est toujours plus nébuleuse. La responsabilité en incombe non seulement aux développeurs du code, mais aux concepteurs des algorithmes, ainsi qu’aux auteurs de la banque de données sur laquelle ces algorithmes sont formés. C’est surtout un problème, lorsque ces algorithmes sont loin d’être parfaits, selon Katleen Gabriels, professeure assistante de Philosophie et d’Ethique informatique à la Technische Universiteit d’Eindhoven.

” Il va de soi que ce sont des applications fantastiques, explique Gabriels. Les algorithmes égalent déjà l’homme, voire le dépassent pour ce qui est de la détection du cancer du sein ou de la peau par exemple. ” Mais parfois, selon elle, il y a un hic, comme le démontre un exemple intéressant qui se manifeste fréquemment : celui du juge-robot.

” En Grande-Bretagne, on a conçu un algorithme ayant comme tâche de vérifier si quelqu’un peut être judiciairement libéré “, argumente Hans Graux. Le logiciel a été formé au départ d’une banque de données contenant quelques milliers de jugements, et l’un des facteurs qu’il en a puisé et sur lequel il a basé ses décisions, semblait être l’heure à laquelle se tenait le procès. ” Or les juges étaient plus rapidement tentés de faire incarcérer les gens, plus on se rapprochait de midi “, ajoute Graux. Au fur et à mesure que les juges ressentent davantage la faim – une réaction très humaine -, ils se montrent plus sévères, semble-t-il. ” Il s’agit là d’un préjugé dont aucun juge n’est conscient, selon Graux. Ce n’est lié ni à la race, ni au sexe, mais c’est simplement une faiblesse humaine. ”

Pour rendre quelqu’un responsable, cette personne doit avoir de l’argent.

Le côté intéressant de cet exemple, c’est évidemment que cette règle avait été explicitement intégrée à l’algorithme, mais pouvait en être supprimée, du moins chez le juge-robot. ” Cela s’avère plus malaisé dans une IA plus complexe et dans les réseaux neuronaux, poursuit Graux. Parce que pour les réseaux neuraux, on imite le plus possible le cerveau humain. On ne peut ainsi pas facilement savoir pourquoi une décision a été prise. ”

La technologie n’est pas neutre

Un algorithme recherche des modèles dans un ensemble de données, sans réflexion particulière. Et tout dépend alors du choix des données. ” Il est important de savoir que cette technologie n’est pas neutre, déclare Gabriels. Elle est formée sur des ensembles de données qui ne sont pas neutres, souvent à cause de données manquantes ou partiales. ”

Il existe suffisamment d’exemples d’IA quelque peu partiale, et ce sont souvent les scénarios les plus sensibles qui font la une de la presse internationale. Comme la reconnaissance faciale qui n’identifie pas les personnes noires, voire qui les assimile à des singes. C’est regrettable, mais cela repose généralement de manière assez inconsciente sur une base de données, à l’instar de ce qui se passe avec le juge-robot. ” En fait, ce sont nos préjugés humains qui s’y infiltrent, selon Gabriels. Si on effectue la formation au départ d’un ensemble de données partial, cela n’aide pas à résoudre les problèmes. Il va de soi que l’objectif est que les algorithmes s’en tirent mieux ou de manière plus objective que l’homme, mais souvent, tel n’est pas encore le cas. “

Pour améliorer les choses, les ingénieurs doivent être plus conscients des problèmes, selon Gabriels, de préférence dès leur formation. ” Il convient donc d’imposer aux ingénieurs de les étudier en profondeur, car ces gens sont appelés à assumer une réelle responsabilité. ”

Graux signale lui aussi que le monde commence à être plus sensible aux implications éthiques des choix des données. Et de citer un exemple. ” La Commission européenne subsidie des masses d’études, et l’une des obligations apparue ces deux dernières années, c’est l’évaluation éthique des effets. ” Quiconque veut obtenir des subsides, doit vérifier si son projet n’aura pas un impact discriminatoire éventuel. ” Cela ne va pas tout résoudre, ne serait-ce que parce qu’il y a parfois des surprises dans les données. Mais cela forcera du moins à y réfléchir, affirme Graux. L’IA peut s’avérer très utile au niveau de la prise de décisions, mais aussi en effectuant un double contrôle. Les gens deviennent à juste titre nerveux lorsqu’il est question de discrimination, mais ils oublient souvent que l’homme lui-même est très imparfait. ”

Robots intelligents et stupides

Début avril, 156 experts en IA de quatorze pays européens ont envoyé une lettre ouverte à la Commission européenne, dans laquelle ils exprimaient leur opposition à accorder une personnalité juridique aux robots. Parmi les signataires, on trouvait notamment des chercheurs IT et des professeurs, dont certains de l’UCL. Leur argument principal, c’est qu’une personnalité juridique n’est pas adaptée aux robots et ce, non seulement dans une perspective légale, mais aussi dans une perspective éthique. L’idée sous-jacente, c’est qu’une telle personnalité ne peut s’appliquer qu’aux robots ‘déterministes’, qui prennent des décisions. Et on en est encore loin, selon Graux. ” Le problème, c’est qu’on a actuellement en tête nombre de scénarios spectaculaires, mais que l’IA elle-même se trouve encore dans une phase très triviale. Il est dangereux de commencer à rédiger des lois sur base de règles fantaisistes. L’AI n’est pas encore suffisamment sophistiquée pour pouvoir prévoir ce que le robot va faire. ”

Le débat sur la personnalité juridique est aussi trop précoce pour Gabriels. ” Beaucoup de nos idées sont alimentées par la science-fiction. Pour l’IA, il faut établir une distinction entre une IA forte et faible. Si les gens craignent une intelligence artificielle consciente ou que des robots partent à la conquête du monde, on parle d’une IA forte, qui n’existe absolument pas encore. L’IA qui existe aujourd’hui, est très limitée. Pensons à Google Translate, aux voitures autonomes ou la reconnaissance de l’image. De l’IA faible. ”

Cette IA faible est aussi celle qui pilote le robot-aspirateur, lorsqu’il heurte avec l’enthousiasme d’une balle en caoutchouc les murs et les meubles du living. ” Les robots vont-ils conquérir le monde ? “, demande le professeur Vanderborght au début de sa présentation lors du festival louvaniste AND&. En arrière-plan, on découvre un montage de quelques minutes, mettant en scène des robots qui chutent continuellement, qui se trompent ou qui s’égarent. ” Ils seront partout, ajoute Vanderborght. Mais on n’en est pas encore au stade où un robot travaille, lorsqu’il est placé dans un environnement qu’il ne connaît pas. ”

Le dilemme du tramway

Il ne s’agit donc pas de Terminators conscients. Les drones militaires, qui sont utilisés depuis des années déjà en des endroits comme l’Afghanistan, afin de détruire des cibles militaires, sont encore souvent commandés par un homme.

Des décès par voie purement logicielle sont enregistrés surtout ailleurs. C’est ainsi qu’en mars dernier, Elaine Herzberg a été renversée et tuée par une voiture autonome d’Uber, alors qu’elle faisait du vélo en Arizona. De l’enquête, il est apparu que la voiture avait bien vu la femme, puisque les voitures autonomes sont équipées de plus de capteurs, de caméras et de… sens que n’importe quel humain, mais que son logiciel avait ‘décidé’ de l’ignorer. Espérons que cela ne sera plus possible dans une prochaine version. ” Les algorithmes des voitures autonomes sont encore en pleine phase d’apprentissage, déclare Katleen Gabriels. Ils vont commettre des erreurs, mais ne dit-on pas que l’on apprend de ses fautes ? C’est certes là une réflexion grinçante et pas vraiment éthique. ”

Le problème, c’est qu’on a actuellement en tête nombre de scénarios spectaculaires, mais que l’IA elle-même se trouve encore dans une phase très triviale.

C’est ce genre de scénario qui provoque actuellement le plus de stress. Dans le cas d’Uber, il s’agissait probablement d’un bug, mais dans d’autres scénarios (particulièrement rares), il est effectivement question de faire un choix entre, disons, renverser un enfant qui traverse subitement la rue ou mettre en danger les quatre occupants de la voiture. C’est ce qu’on appelle le ‘dilemme du tramway’. Ce sont des choix éthiques que les chauffeurs humains doivent faire en une fraction de seconde, mais qui, chez les robots, doivent émaner du code.

Le plus important, selon Hans Graux, c’est qu’il faut effectivement les encoder à l’avance. ” Les gens qui développement ce genre de produits, doivent procéder à un ‘impact assessment’, à savoir une évaluation par laquelle ils spécifient eux-mêmes quels sont les dangers de leur produit. Et ce qu’ils font pour les contrer. ” Cela ne résout pas le problème du tramway, admet-il, mais le premier pas consiste à y réfléchir.

Un point essentiel dans ce cas, d’après Graux, c’est qu’il faut aussi avoir une vision globale. ” La Belgique est un pays qui recense beaucoup d’accidents de circulation mortels : 800 personnes perdent ainsi la vie par an. Supposons qu’avec les voitures autonomes, on puisse réduire ce nombre à 200. Si quelqu’un de proche figure parmi ces 200, vous trouverez cela ignoble. Surtout si le robot fait le choix de tuer votre enfant. Mais pour la société, cela peut être un bon résultat. Les gens ont tendance à s’accrocher à des scénarios-catastrophes individuels, mais oublient que la société dans son ensemble appréciera. Pourquoi un robot a-t-il pris telle décision et la société va-t-elle l’approuver ? Voulons-nous qu’il en aille autrement ? Si une personne tue quelqu’un sur la route, cela génère en général une réaction de panique. Pour les robots, cela prête davantage à la réflexion, ce qui est un avantage. ”

Gabriels, elle aussi, trouve que la question éthique ne peut être laissée en suspens. ” Il convient de la programmer dans la technologie. A l’université d’Eindhoven, tous les étudiants reçoivent obligatoirement un cours d’éthique d’ingénierie. Il est question de ‘value sensitive design’, afin de sécuriser les valeurs éthiques au lieu de les mettre davantage encore sous pression. ” Et de citer l’exemple du GDPR, qui cible le même but avec le ‘privacy by design’. ” Si on peut reprendre cela dans la formation, à savoir le fait d’y réfléchir et de collaborer préventivement, je pense alors que la technologie pourra faire toujours mieux. “

Et la législation actuelle ?

Que les choses soient claires : tout le débat ne signifie pas que l’on soit entièrement sans protection actuellement. ” Nous ne disposons certes pas de règles pour les robots, explique Hans Graux. Mais il existe depuis longtemps déjà des règles pour la sécurité des produits, et notamment l’équipement électronique ou les jouets robotiques auxquels les enfants peuvent parler. Ce sont en soi des appareils qui doivent satisfaire à des règlements de sécurité spécifiques. “