Qu’implique la percée, et parfois la domination, des hyperscalers sur les centres de données locaux ? Pour les acteurs belges, le défi consiste à trouver un équilibre entre concurrence et collaboration avec AWS, Azure, Google et consorts.

Pour les entreprises, le centre de données est le coeur de leur infrastructure numérique. Sans centre de données, pas de disponibilité 24/7 des applications, pas de télétravail, mais aussi aucune possibilité d’évoluer à l’infini pour absorber les pics. Mais ce coeur est également en constante évolution. Voici 15 à 20 ans, on parlait plutôt de ‘data room’ ou de salle de serveurs dans le sous-sol de l’entreprise. Depuis lors, le nombre de fournisseurs de centres de données désireux de vous faire migrer vers le cloud a explosé. ” Ne le faites pas vous-même, mais louez-nous l’infrastructure “, justifiaient-ils.

Nuages à l’horizon

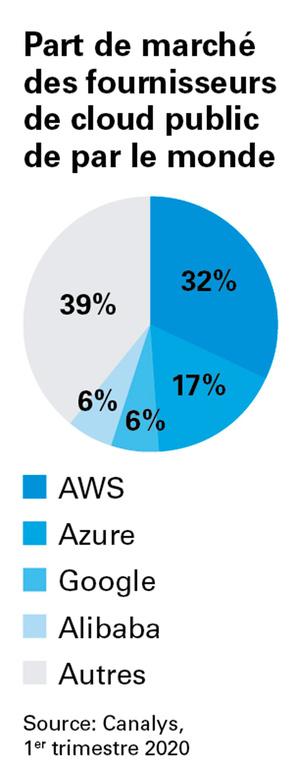

Désormais, le cloud se présente sous différentes variantes. Tout en haut du marché, on retrouve les fameux hyperscalers. Les entreprises Amazon Web Services, Microsoft Azure, Google Cloud Platform sont les plus connues, mais on retrouve également IBM, Oracle, Alibaba, Huawei et autres qui souhaitent héberger vos applications dans leurs infrastructures de pointe. Leur avantage majeur est d’être largement automatisés et présents à l’échelle mondiale. Si vous savez ce dont vous avez besoin, il suffit d’une carte de crédit pour se lancer. Si vos clients sont surtout en Europe occidentale mais que vous avez un pic en provenance des Etats-Unis, un tel hyperscaler peut parfaitement déplacer votre charge de travail vers un centre de données américain. Une solution qui se révèle également intéressante en cas de panne.

Nous ne sommes pas plus chers qu’un AWS ou qu’un Proximus ou un Telenet. ” Manu Drieghe (Unix-Solutions)

Au niveau inférieur, on retrouve des acteurs de centres de données qui, par leur taille ou leur position internationale, sont actifs dans plusieurs pays. Eux aussi offrent la possibilité de faire tourner un service de manière aussi performante tant à Bruxelles qu’à Singapour.

Mais le présent article se focalise sur les acteurs locaux. Comment se mesurent-ils aux grands et très grands fournisseurs ? Quelle est, dans un pays relativement petit, la plus-value des centres de données locaux par rapport aux géants qui disposent de centres de données à Londres, Franfort, Paris ou Amsterdam ?

Concurrence ou co-innovation ?

Data News a rencontré quatre acteurs locaux : Unix-Solutions, LCL, Proximus et Cegeka. Chacun adopte sa propre stratégie ou dessert un marché spécifique, mais ils avancent tous leurs arguments à la question de savoir ce que peut offrir leur infrastructure à l’heure où un acteur mondial peut offrir de la capacité informatique infinie.

Ainsi, Unix-Solutions est le plus petit des quatre acteurs. L’entreprise possède un centre de données à Zaventem et un à Louvain, soit 326 baies ou 805 m2 d’infrastructures. Après avoir entamé ses activités comme service d’hébergement, l’entreprise fournit des services de centre de données et connaît une croissance constante, ciblant spécifiquement le marché des PME avec ses quelque 250 collaborateurs. ” Nous ne considérons pas les grands acteurs comme des concurrents, insiste Manu Drieghe, ‘managing partner’. Les entreprises qui nous contactent privilégient une approche personnelle et flexible, alors que chez un grand prestataire, vous finissez quelle que soit la situation, par devoir appeler un helpdesk, parcourir un menu et répondre à une série de questions standards. Alors que si vous nous appelez, nous vous venons en aide dans la journée. ”

Par ailleurs, les prix que proposent les hyperscalers pour attirer leurs clients n’impressionnent guère Drieghe. ” Nous ne sommes pas plus chers qu’un AWS ou qu’un Proximus ou un Telenet. Nous constatons parfois que tout va bien chez un client qui tourne une application parfaitement contrôlable dans AWS, mais qu’une fois en production, le nombre d’utilisateurs et le trafic de données augmente, avec une facture en conséquence. Parfois par mégabits [la bande passante, NDLR], parfois par volume de données. Mais souvent, cette facture passe de quelque 100 ? par mois à plus de 1.000 ? par mois. Nous ne pouvons pas offrir ce ‘one-click-shop’, mais notre service est très personnalisé et nous sommes très transparents sur les prix. ”

” Chez nous, vous payez également plus si vous utilisez davantage de capacité que prévu, mais nous contactons les clients de manière proactive, ajoute Steven Bens, fondateur. De même, nous ne regardons pas le trafic par Go, mais bien une moyenne par mois. Alors que chez AWS, vous ne pouvez pas savoir comment évolue le prix en cas d’explosion d’une application. Cela peut prendre toutes les directions. ”

Chez LCL également, qui vient de racheter un 4e centre de données à Huizingen, les hyperscalers sont classés dans une autre catégorie. LCL ne propose pas de serveurs, mais de la co-location, entendez de l’espace pour installer des serveurs, y compris la connectivité avec les principaux acteurs télécoms et des connexions directes avec les grands fournisseurs cloud. Chez LCL, l’accent est surtout mis sur la qualité des services fournis ; ainsi, tous les centres de données sont de niveau ‘tier 3’. ” Nous nous différencions précisément par cette connectivité, indique Laurens Van Reijen de LCL. Nous supportons 40 opérateurs télécoms. Nous privilégions la proximité et l’accessibilité, et nous considérons les très grands acteurs plutôt comme des partenaires. Avec ECX Fabric, nous disposons d’une plateforme permettant de les connecter directement, ce qui est intéressant pour les entreprises puisqu’elles peuvent ainsi externaliser leur propre salle de serveurs à un acteur comme LCL tout en disposant d’une connectivité performante avec d’autres fournisseurs cloud dans la mesure où la latence entre leurs serveurs et les hyperscalers est très faible. ”

Quant à Proximus qui, outre les télécoms et la connectivité via deux centres de données (plus deux à Luxembourg), commercialise des services cloud, la position est plus explicite encore. ” Nous ne voulons absolument pas de produit qui soit en concurrence avec Azure “, insiste Gaetan Willems, ‘head of hybrid cloud’ chez Proximus. L’entreprise préfère également privilégier la collaboration où une charge de travail tourne chez Proximus ou un autre grand fournisseur cloud en fonction des besoins. ” Nous souhaitons être un guichet unique pour la connectivité, le centre de données et l’infrastructure dans le Benelux, mais nous désirons également collaborer afin de pouvoir également offrir les plateformes d’un hyperscaler à nos clients. ”

C’est ainsi que depuis avril, Proximus a conclu un partenariat avec Azure concernant Azure Edge Zones. ” Ce faisant, nous rapprochons Azure du client, dans notre propre centre de données, sur-site ou ailleurs “, précise Willems.

De son côté, Cegeka adopte une stratégie similaire. L’entreprise propose un éventail de services de centre de données, mais toujours dans le cadre d’un contrat d’externalisation. ” Parfois, nous gérons à distance le cloud privé du client, parfois l’infrastructure est hébergée chez nous pour pouvoir assurer, tout comme un hyperscaler, l’élasticité nécessaire, mais dans la pratique, il s’agit souvent d’une solution hybride, note Stijn Bijnens, CEO. Car si la solution de l’hyperscaler est meilleure, pourquoi ne pas l’adopter ? ” Cela dit, il se dit partisan de l’approche proposée aujourd’hui par les grands acteurs cloud, même s’il n’y voit pas la panacée. ” Le cloud public est comme un hamburger de McDonalds : on sait comment il est fabriqué, mais il est impossible d’en commander un avec deux cornichons et pas de fromage. ” Bref, en cas de besoin spécifique, mieux vaut s’adresser à des acteurs locaux, souvent plus flexibles.

Nous ne voulons absolument pas de produit qui soit en concurrence avec Azure. ” Gaetan Willems (Proximus)

” Si vous êtes une start-up qui propose une nouvelle appli numérique, développez-là dans Azure ou AWS. Mais nos clients ont souvent un héritage, notamment des applications développées voici 20 ans qu’il faut moderniser et basculer dans le cloud. En même temps, le cloud est souvent présenté de manière simplifiée, alors que se posent des questions de gestion du changement, de cybersécurité, de gestion, etc. Nous avons des clients qui sont largement dans Azure, mais pour lesquels nous prenons en charge la gestion. C’est ce type de solution totale que nous offrons dans notre ‘sweet spot’ “, souligne Bijnens.

Barre très haut

Les hyperscalers ont profondément bouleversé le paysage IT, mais surtout en positif. ” Ils ont surtout amélioré l’expérience utilisateur, ce qui nous incite à investir également dans nos solutions pour en renforcer la facilité d’utilisation “, confie Willems (Proximus). ” Ils mettent la barre très haut, notamment pour leur portail clients. Mais aussi la tarification “, ajoute Bijnens (Cegeka). ” Autrefois, il était possible de gérer une infrastructure pour un prix déterminé, mais désormais, chaque acteur détaille le coût de la puissance de calcul, d’un conteneur, d’un ‘cluster’, d’une sauvegarde, etc. Désormais, il y a beaucoup plus de transparence sur les prix, ce qui est tout profit pour le client. ”

Drieghe (Unix-Solutions) : ” Nous constatons surtout un regain d’intérêt pour les centres de données. Le RGPD a obligé les clients à regarder où se trouvaient effectivement leurs données, soit notamment Paris, Francfort ou Amsterdam pour les grands acteurs. Chez nous, il s’agit de Zaventem ou de Louvain et certains clients estiment important que leurs données restent en Belgique. ” Cela dit, le fait que les grands acteurs proposent leur cloud partout dans le monde n’incite pas forcément les clients à tourner le dos aux fournisseurs locaux, comme le note son collègue Steven Bens. ” Tant que votre entreprise est en phase avec la technologie, les clients n’éprouvent pas forcément le besoin de s’adresser à un grand acteur. C’est ainsi que nous sommes en train de proposer Kubernetes. De même, vous pouvez chez nous grandir en capacité, tandis que nos systèmes fonctionnent également en 24/7. ”

Matériel contre logiciel

Ces 10 dernières années, la croissance du cloud s’est également traduite par une augmentation des logiciels gérés dans le cloud. Au point d’ailleurs que certains acteurs estiment depuis un certain temps déjà que le matériel est désormais moins important que le logiciel qu’il faut gérer et optimiser. Une affirmation partiellement exacte. ” Pour les services partagés, c’est en effet moins important, note Willems (Proximus). Mais si votre client a des besoins spécifiques, par exemple pour une application particulière, le matériel et les performances se révèlent importantes. Il peut alors s’agir de capacité de stockage ou d’infrastructure hyperconvergée. ”

Pour sa part, Van Reijen (LCL) se veut plus nuancé. ” C’est tout aussi important, mais nous avons maintenant une approche différente. Un serveur peut coûter aujourd’hui 10 ou 20 fois plus qu’il y a 10 ans, mais ses performances sont nettement supérieures. Dans le même temps, la capacité en RAM ou en stockage reste importante. ”

De son côté, Unix-Solutions envisage différemment les choses. ” Le logiciel nous permet de continuer à innover, affirme Bens. Nous essayons d’être moins dépendants d’un matériel spécifique. L’ensemble de notre environnement ‘cluster’ est construit de telle manière que les composants puissent continuer à fonctionner si un serveur ou un commutateur s’arrête de fonctionner. De même, si nous devions tout perdre sur un site suite à une panne ou un incendie, le logiciel nous permet de continuer à tout faire fonctionner sur un autre site. La dépendance vis-à-vis d’un matériel spécifique a diminué, mais il faut pour cela prévoir de la virtualisation et des logiciels spécifiques. ”

Un raisonnement que tient également Bijnens (Cegeka). ” Je partage pleinement l’idée selon laquelle tout sera migré vers du matériel polyvalent, mais j’ajoute qu’en tant qu’ingénieur en logiciels, je ne suis pas un spécialiste du matériel. Le ‘software defined networking’ s’impose toujours plus et le matériel deviendra à terme invisible aux yeux du développeur. Mais cela complique parfois les choses. Autrefois, en cas de problème de réseau, il suffisait de retirer un câble pour en connaître la cause. Mais avec le ‘software defined’, c’est plus compliqué, même si cela devrait en principe fonctionner mieux. ”

Covid-19

Nous interrogeons nos 4 interlocuteurs en plein télétravail. Une période durant laquelle le trafic réseau explose, tandis que les entreprises ont dû s’adapter très rapidement pour rendre leurs applications accessibles à distance. Une situation qui les a impactés. ” La demande a augmenté pour certains produits comme un VPN ou un poste de travail numérique “, indique Willems (Proximus). Chez Unix-Solutions également, certains clients ont augmenté la capacité de leur centre de données.

” La plupart des choses passent relativement inaperçues, observe Van Reijen (LCL). Certains clients font passer leurs connexions de 1 Gbit/s à 5 Gbit/s. Certains opérateurs nous disent que leurs clients dopent leurs réseaux. Mais l’avantage de notre secteur est d’offrir un maximum d’évolutivité. La taille de l’Internet double environ tous les 18 mois et l’infrastructure est adaptée en conséquence. Cela permet de s’adapter très rapidement à toute évolution. ”

Cela étant, l’IT n’est pas totalement épargnée. Ainsi, Gartner prévoit cette année une baisse de 8% des investissements en informatique par rapport à 2019, alors qu’en début d’année, le cabinet tablait encore sur une croissance de 3,4%. Soit une différence dans les estimations de 409 milliards $.

” On risque sans doute demain la récession, ce qui incitera les clients à postposer leurs nouveaux projets. Mais dans le même temps, l’importance de l’IT est devenue telle que beaucoup d’entreprises se rendent compte que faire des économies majeures n’est pas forcément une bonne chose “, note Van Reijen (LCL). Pour sa part également, Willems (Proximus) se montre relativement positif. ” Certains projets seront retardés. Mais au lieu d’investissements majeurs, nombre d’entreprises s’intéresseront à un modèle de location. Du coup, les services gérés sur notre plateforme ou dans le cloud public prendront de l’importance. Dans un tel cas, pas forcément pour optimiser le fonctionnement d’une application, mais pour des questions de coûts. ”

” Aujourd’hui, je suis content de travailler dans l’informatique et pas dans un autre secteur, déclare Bijnens (Cegeka). Mais fondamentalement, je pense que la numérisation va s’accélérer. Subitement, deux milliards de personnes dans le monde ont appris à travailler à distance, d’où l’importance croissante de la gestion numérique du poste de travail et des concepts associés au cloud. Car cela permet à la fois d’upscaler, mais aussi de downscaler, ce qui est tout l’intérêt du cloud. ”

Le centre de données pour les nuls

Vous savez sans doute ce qu’est un centre de données, mais il existe de nombreux termes techniques ou mots en vogue que vous ne maîtrisez peut-être pas. Pas de panique, Data News vous explique clairement ces notions qui vous permettront demain de négocier avec votre fournisseur de centre de données.

Serveur (lame)

Un serveur spécifiquement conçu pour le centre de données et dont l’encombrement est réduit au maximum pour optimiser la densité de serveurs. En termes de taille, il s’agit en somme d’une boîte à pizza.

Colocation (colo)

Un centre de données où l’on ne loue pas des serveurs, mais où l’on peut installer ses propres équipements. Le centre de données assure l’alimentation électrique, la connectivité avec différents opérateurs télécoms ou acteurs cloud. Vous restez responsable de votre matériel, mais tout le reste est livré par le centre de données.

Conteneur

Comparable à une machine virtuelle, mais qui comporte uniquement l’application. Il s’agit donc d’une VM légère. En outre, une application dans un conteneur peut être plus facilement déplacée d’un serveur à un autre, par exemple d’un environnement de test à un environnement de production.

Reprise après sinistre

Un ensemble de mesures permettant d’assurer la continuité d’activités en cas d’incident (incendie, inondation, panne). Au niveau d’un centre de données, cela signifie notamment la présence d’un générateur de secours pour garantir l’alimentation électrique en cas de panne prolongée ainsi qu’une copie des données et des applications dans un 2e ou un 3e centre de données distant d’au moins 20 km.

Centre de données hyperscale

Les hyperscalers sont de très grands centres de données actuellement aux mains d’entreprises technologiques, qu’il s’agisse surtout d’AWS, Google et Azure, mais aussi Facebook et Apple qui n’offrent pas leur puissance de calcul à des tiers.

Salle ‘meet me’

Une salle au sein d’un centre de données où arrivent les connexions des différents opérateurs télécoms. Il s’agit donc d’un noeud physique pour les connexions de données.

Sur-site

Lorsque l’entreprise utilise ses propres serveurs ou son centre de données en interne, on parle de ‘on-premise’.

Cloud public, privé, hybride et multicloud

Si vos données sont dans un cloud public, elles sont stockées sur des serveurs partagés avec d’autres entreprises ou utilisateurs. Certes, vos données sont (en principe) scindées de celles des autres clients, mais vous partagez l’infrastructure. En cas de cloud privé, le matériel qui traite vos données vous appartient. Il peut s’agir de serveurs qui vous appartiennent, mais aussi d’une infrastructure dans un centre de données externe. Un cloud hybride est une combinaison de cloud privé et public. Enfin, un multicloud associe plusieurs fournisseurs de cloud. Ainsi, une application peut tourner sur Amazon, une autre chez Cegeka et un 3e projet chez Oracle par exemple.

PUE

Power Usage Effectiveness ou ‘indicateur d’efficacité énergétique’. Il s’agit de la consommation totale d’énergie du centre de données divisée par la consommation énergétique des équipements IT. Ce chiffre se situe en général vers 1,2 à 1,4 et indique l’efficacité énergétique : plus le chiffre est élevé, plus l’énergie consacrée au refroidissement notamment est importante et donc plus la consommation d’électricité augmente (et donc les coûts).

Baie

Une armoire qui renferme essentiellement des serveurs.

Redondance/dédoublement

Une infrastructure permettant de basculer sur une connexion et/ou une capacité alternative(s) en cas de problème. Au niveau du centre de données, cela implique notamment qu’il existe au moins deux connexions Internet d’opérateurs différents, deux raccordements au réseau électrique et qu’une copie des données est stockée sur un autre site.

Tier 1, 2, 3…

Une norme relativement universelle indiquant le niveau d’équipement d’un centre de données. Ainsi, un centre ‘tier 1’ ne dispose que d’une seule source d’alimentation et de refroidissement et garantit un taux de disponibilité de 99,671% par an (soit 28,8 h d’interruption par an). Pour un ‘tier 3’, il faut disposer de plusieurs entrées d’alimentation et de refroidissement, ce qui permet de garantir une disponibilité de 99,995%, soit à peine 26 minutes d’interruption par an. Enfin, le ‘tier 4’ existe également, mais difficile à appliquer en Belgique puisqu’il faut une connexion à deux réseaux électriques différents, alors que la Belgique compte certes plusieurs fournisseurs d’électricité, mais un seul réseau électrique. En théorie, il peut certes s’agir de combiner une deuxième source d’alimentation permanente, comme une centrale hydroélectrique interne.

Machine virtuelle

La version virtuelle d’un ordinateur ou d’un serveur. Ainsi, un seul serveur physique peut tourner plusieurs machines virtuelles (VM), ce qui se révèle pratique pour exploiter par exemple plusieurs systèmes d’exploitation ou pour affecter un serveur virtuel à un groupe d’utilisateurs ou de clients.