La percée de la voiture sans chauffeur coïncide avec la naissance de plusieurs dilemmes moraux et éthiques. La voiture autonome doit-elle par exemple sacrifier un passager pour épargner la vie de plusieurs autres sur la route?

Supposons que vous vous trouviez dans une voiture autonome et qu’après un virage, il soit impossible à celle-ci d’éviter un groupe de 10 personnes qui marchent sur la rue cernée par des murs des deux côtés. La voiture doit-elle heurter dans ce cas une paroi au risque de vous blesser, voire de vous tuer? Ou doit-elle tenter de stopper au risque de renverser le groupe, mais en vous épargnant?

Telle est la question que se sont posés des chercheurs de la Toulouse School of Economics, et sur laquelle I Fucking Love Science s’est penché.

Cette situation hypothétique devient toujours plus vraisemblable avec la percée de la voiture (partiellement) autonome. Actuellement, ces voitures ne circulent que sur des autoroutes, pour justement éviter ce genre de problème. Car avant que les voitures sans chauffeur ne circulent partout, il convient d’aborder ce genre de questions éthiques, affirment les chercheurs. La façon dont ces questions seront résolues, s’avérera essentielle à l’avenir au niveau de l’application de cette technologie.

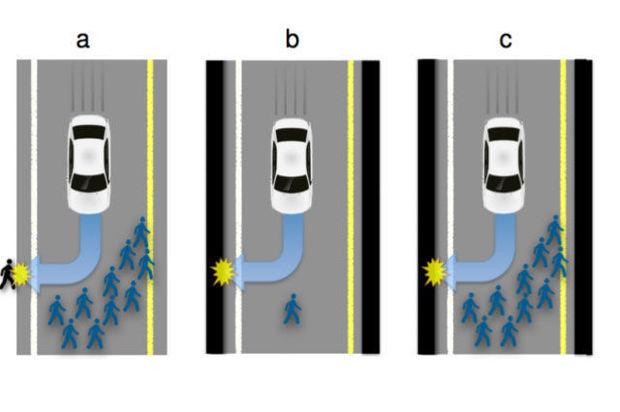

Les chercheurs ont présenté l’exemple des piétons sur la route à un groupe de personnes et ce, selon divers scénarios. Ils ont par exemple adapté le nombre de passagers à bord de la voiture, le nombre de personnes marchant sur la route, ainsi que l’âge des passagers de la voiture, jusqu’à envisager aussi la présence d’enfants.

Se sacrifier pour le groupe

Le résultat obtenu n’est peut-être pas très étonnant: les gens souhaitent sacrifier le passager (ou le conducteur en cas d’une voiture partiellement autonome) de la voiture pour épargner le groupe. Mais ils ne réagissent ainsi surtout s’ils ne se considèrent pas eux-mêmes comme passager. 75 pour cent des répondants trouvent normal que la voiture bifurque pour heurter le mur, mais seuls 65 pour cent estiment que la voiture doit être réellement programmée pour ce faire. “Sur une échelle de -50 (protéger le passager envers et contre tout) à +50 (sauver autant de vies que possible), la moyenne s’inscrit à +24”, indiquent les chercheurs.

Zone grise

Le résultat de l’enquête englobe une zone grise: faut-il voter des lois pour faire en sorte que les voitures autonomes ‘prennent’ à tous les coups la froide décision de sauver le grand groupe de personnes? Ou peuvent-elles être paramétrées selon différentes formes de logique? “Si un constructeur propose plusieurs versions de l’algorithme moral et que l’acheteur en choisit un, ce dernier assumera-t-il la responsabilité en cas d’accident?”, se demandent encore les chercheurs.

Ce type de dilemme fait en sorte que les voitures autonomes ne sont pas prêtes de circuler massivement sur toutes les routes. Il convient d’abord que la législation soit adaptée.

Plus sûr que l’humain

Mais malgré les dilemmes moraux, les chercheurs du MIT affirment que les voitures autonomes sont plus sûres que celles conduites par des conducteurs humains. “Si moins de personnes achètent une voiture autonome parce qu’elle a été programmée pour tuer le passager en cas de situation telle que décrite ci-avant, il n’en reste pas moins vrai qu’il continuera d’y avoir plus de tués sur les routes en utilisant les voitures traditionnelles suite à des accidents nettement plus nombreux”, écrit le MIT. “Il en résulte une situation de type Catch-22”, à savoir une situation où le choix n’est pas possible.

Il ne fait guère de doute que l’avenir de la voiture sera à l’autonomie, mais comme l’étude le démontre, il existe encore de très grands défis à relever, avant d’y arriver.