Un institut de recherche japonais autorise HPE à construire un nouveau superordinateur qui se concentrera spécifiquement sur l’IA. Nvidia fournira également ses GPU H200 pour garantir la puissance de calcul nécessaire.

Le système ABCI 300, qui signifie AI Bridging Cloud Infrastructure, sera un service cloud destiné aux organisations publiques et privées. La machine elle-même sera achetée par l’AIST, un institut national de recherche en sciences et technologies industrielles avancées.

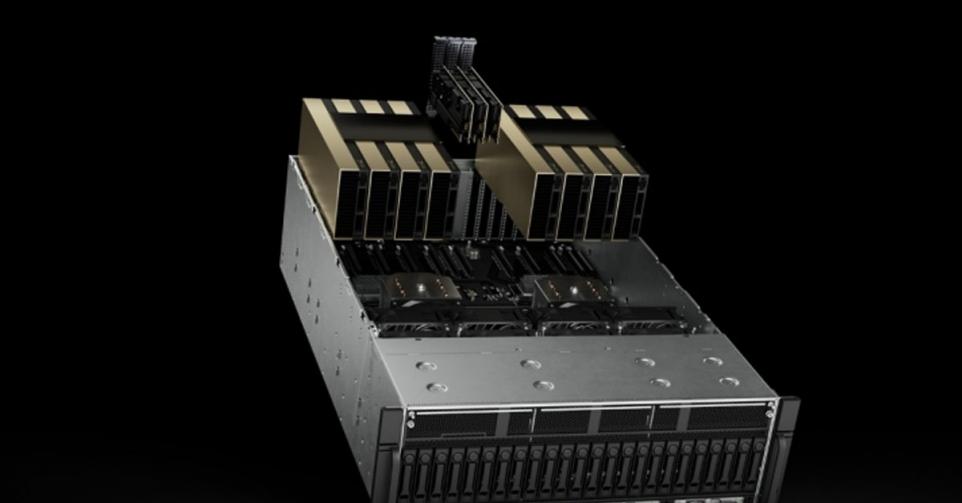

HPE construira la machine avec des modules Cray XD, complétés par un équipement réseau Quantum-2 InfiniBand de Nvidia. Le site The Register fait observer qu’il s’agira probablement du Cray XD670, capable d’accueillir huit GPU Nvidia H200 ou H100 (et occupant 5U d’espace dans une armoire).

La machine devrait devenir le superordinateur d’IA le plus rapide du Japon avec un maximum théorique de 6,2 exaflops. Pour être plus précis, sachez qu’en 2022, le superordinateur le plus rapide du monde a été le premier à disposer d’une puissance de calcul supérieure à un exaflop. Il y a quelques mois, la société pharmaceutique Novo Nordisk (la firme à l’origine d’Ozempic) avait annoncé un superordinateur d’une puissance de 6 exaflops.

En clair, ces performances maximales (souvent théoriques) sont avant tout une indication et non une certitude absolue. La puissance d’un superordinateur dépend également de ce qui est calculé (et comment), alors que l’efficience et l’évolution du software jouent également un rôle.

Souveraineté de l’IA japonaise

Nvidia déclare que ce genre d’investissement est positif pour la souveraineté du Japon en matière d’IA. Une affirmation à laquelle l’entreprise fait souvent référence: chaque pays doit disposer de sa propre infrastructure pour pouvoir réaliser des développements de l’IA, au lieu de compter sur les autres.

Il va de soi qu’une telle déclaration a aussi un côté commercial. Les GPU H200 coûtent des dizaines de milliers de dollars pièce. Il serait bien sûr plus intéressant pour Nvidia que chaque pays ou institut de recherche construise un ou plusieurs superordinateurs avec ces puces, au lieu de partager les ressources entre eux.